- Vous n'êtes pas identifié.

Annonce

#1 2011-09-05 12:27:21 Demande de retours d'expérience Kinect et Max

- Jitcode

- membre

- Date d'inscription: 2010-08-19

- Messages: 50

Demande de retours d'expérience Kinect et Max

Bonjour,

La kinect n'a pas été évoquée sur ce forum, il existe pas mal de choses en anglais sur la question, mais je suis assez limité dans cette langue d'où ce post.

Je ne possède pas la kinect et ne peux donc tester ce patch de Jean-marie Pelletier : http://jmpelletier.com/freenect/.

Quels types de paramètres extrait-on ?

D'autre part j''ai vu qu'il existait des clones moitié moins chers, mais j'ignore si ils sont compatibles.

http://www.clubic.com/jeu-video/kinect/ … ct-60.html

D'avance merci.

Hors ligne

#2 2011-09-05 15:13:23 Re : Demande de retours d'expérience Kinect et Max

Re: Demande de retours d'expérience Kinect et Max

Jitcode a écrit:

Bonjour,

La kinect n'a pas été évoquée sur ce forum, il existe pas mal de choses en anglais sur la question, mais je suis assez limité dans cette langue d'où ce post.

Je ne possède pas la kinect et ne peux donc tester ce patch de Jean-marie Pelletier : http://jmpelletier.com/freenect/.

Quels types de paramètres extrait-on ?

tous les paramètres fournis par la Kinect ![]()

citation :

D'autre part j''ai vu qu'il existait des clones moitié moins chers, mais j'ignore si ils sont compatibles.

http://www.clubic.com/jeu-video/kinect/ … ct-60.html

mmh, j'ai du mal à y croire mais bon...

sinon j'ai testé la Kinect sous MaxMSP y a qques mois pour aider qqu'un (avec le même patch que toi).

ca marchait vraiment bien et c'était rapide à comprendre/utiliser.

je n'ai pas trop poussé les tests vu que nous avons préféré utiliser pure-data pour le projet final ![]()

++

_y

Hors ligne

#3 2011-09-06 10:05:45 Re : Demande de retours d'expérience Kinect et Max

- Jitcode

- membre

- Date d'inscription: 2010-08-19

- Messages: 50

Re: Demande de retours d'expérience Kinect et Max

{yv} a écrit:

tous les paramètres fournis par la Kinect

Merci pour ta réponse rapide.

J'ai ouvert le patch d'aide de JM Pelletier et ça m'éclaire peu, il faut dire que je ne connais pas l'environnement de la kinect. J'espère en avoir une sous la main pour me faire une idée. Je ne pense pas utiliser tout au départ.

Jusqu'à combien de mètres la kinect peut capter les mouvements ?

Il y a une distance idéale ?

Au-dessus et en deçà de cette distance idéale on perd en précision ?

Hors ligne

#4 2011-09-06 11:24:06 Re : Demande de retours d'expérience Kinect et Max

Re: Demande de retours d'expérience Kinect et Max

Bonjour,

il y a deux capteurs dans la kinect : une webcam traditionnelle et un capteur 3D, qui permet de faire un relevé des formes dans un espace en 3D, voila pour le côté hardware. Ces données sont ensuite traitées par logiciel, ce qui permet par exemple de séparer des formes (détection et trasking de blobs) et de les suivre pour de la reconnaissance de gestes, il y a un ensemble de logiciel qui permet aussi de définir le "squelette" d'une personne et d'en suivre les mouvements. Je n'utilise pas max, et donc pas jit.freenect mais en voyant le site, j'ai l'impression que ça permet détection de blobs et tracking, pas de reconnaissance de geste ou de squelette. Peut-être qu'il y a d'autres objets pour traiter les données à la suite?

Jitcode a écrit:

Jusqu'à combien de mètres la kinect peut capter les mouvements ?

Il y a une distance idéale ?

Au-dessus et en deçà de cette distance idéale on perd en précision ?

Jusqu'à 3.30 mètres environ la détection est précise, plus la distance est importante, moins la distinction en profondeur est précise. Ça dépend aussi de la luminosité et de l'environnement, s'il est très encombré, il y aura plus de parasites

Si tu veux approfondir le sujet, je te suggère de commencer par ici : http://wiki.labomedia.org/index.php/Kinect

Hors ligne

#5 2011-09-06 17:11:28 Re : Demande de retours d'expérience Kinect et Max

- Jitcode

- membre

- Date d'inscription: 2010-08-19

- Messages: 50

Re: Demande de retours d'expérience Kinect et Max

emoc a écrit:

Jusqu'à 3.30 mètres environ la détection est précise, plus la distance est importante, moins la distinction en profondeur est précise. Ça dépend aussi de la luminosité et de l'environnement, s'il est très encombré, il y aura plus de parasites

Donc pour un petit plateau, c'est déjà pas mal.

Merci pour le lien.

Dernière modification par Jitcode (2011-09-06 17:22:44)

Hors ligne

#6 2011-09-07 21:27:29 Re : Demande de retours d'expérience Kinect et Max

Re: Demande de retours d'expérience Kinect et Max

Bonsoir,

A ma connaissance la kinect est en effet constituée de deux capteurs, comme la indiqué emoc.

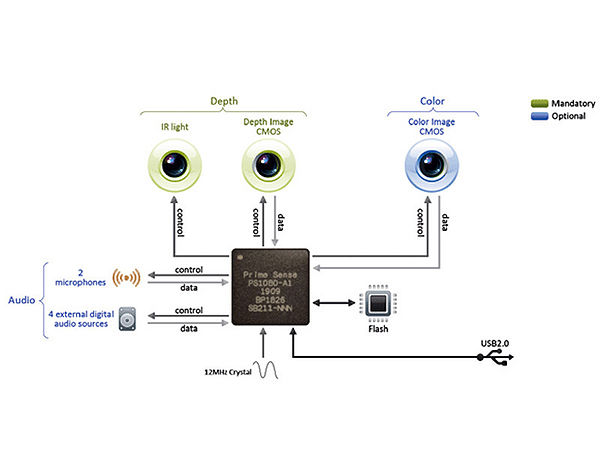

le capteur RGV est une caméra normale à la résolution 640x480, l'autre capteur, dit "de profondeur" est un télémètre constitué d'une série de faisceaux infra-rouges. Le système interne de la kinect calcul donc le temps parcouru par l'infrarouge pour déterminer la distance de l'objet ou du sujet et donc la profondeur de champ.

Ce problème de la distance est un vrai problème avec la kinect mais à ce prix-là il ne faut pas en attendre d'immenses performances, ce qui reste assez paradoxal avec le fait que l'on est tout de même dans une haute technologie, qui trouve son origine initiale dans des applications militaires (voir plus bas mon développement sur la société PrimeSense).

D'après nos tests au studio la caméra capte jusque 8 mètres péniblement, à 5 mètres ça reste exploitable, l'idéal est entre 1m50 et 3m50 max.

Ce problème de la distance avec la kinect est très bien expliqué ici par Jean-Marc Pelletier:

http://cycling74.com/forums/topic.php?id=29987

En quelques mots Kinect est la réponse à la Wii MotionPlus de Nintendo et à la Move de Sony (PlayStation). Bien auparavant Sony avait commercialisé la caméra EyeToy qui permettait également de jouer à des jeux grâce à des procédés de détection de mouvement.

2.5 million d'unités ont été vendues au premier mois de commercialisation. Un immense succès qui dépasse l'attente de Microsoft.

La kinect tient sa technologie de la société israélienne PrimeSense.

Cette de technologie, dite de Z-Cam ou caméra de profondeur est un peu le graal de la robotique, qu'elle soit militaire ou civile.

Il est très probable que Primesense ait à l'origine tenté de répondre à des projets militaires avec ce capteur. Toutefois, il est relativement mauvais pour un capteur robotique (mais incroyablement peu cher!).

Il est probable qu'avec le succès de la kinect, Primesense se soit totalement repositionnés sur le loisir et le jeu vidéo, comme semble l'attester leur site:

http://www.primesense.com/#3

Suite au succès de la kinect Primesense à créé une NPO (Non-Profit Organisation, équivalent d'une association en France):

OpenNI pour "Open Natural Interface" qui à pour objectif de promouvoir les dispositifs et les applications qui reposent sur les procédés de vision de la kinect.

A ce titre ils ont publié un SDK qui permet d'exploiter une partie des capacités de détection de mouvement de leur capteur. Ce projet donne des outils aux développeurs mais le code source n'est en partie pas livrée, c'est juste un environnement de développement:

http://www.openni.org/

En revanche il essaient de fédérer une communauté en proposant aux créateurs de projets de toutes natures (jeux, arts) de publier leurs sources selon un guide de directives et une "charte". Certains ici ont peut-être reçu un courrier d'OpenNI dans ce sens.

Un objet [jit.openni] pour windows repose sur cette librairie

http://cycling74.com/forums/topic.php?id=34020

Par ailleurs un autre projet, en code source ouvert celui-ci s'est lancé par la communauté, OpenKinect:

http://openkinect.org/wiki/Main_Page

L'objet [jit.freenect.grab] pour Mac ,

http://jmpelletier.com/freenect/

est basé sur la librairie Libfreenect qui est issue du projet OpenKinect. Nombre d'objets ou librairies dans d'autres environnements reposent sur cette librairie véritablement ouverte et collaborative. D'autres ont choisi OpenNI.

Quelques autres sources

• applications de calibrage très complète pour Linux, Mac, Windows

http://nicolas.burrus.name/index.php/Re … tRgbDemoV5

• estimation de posture

TOHM JUDSON a posté un tutoriel pour relier OpenNI à Max en OSC pour faire du "Skeleton tracking"

http://tohmjudson.com/?p=30

C'est un peu fastidieux car il y a pas mal de chose à installer via le terminal mais c'est très bien expliqué et ça fonctionne bien.

J'ai réalisé un test ici:

http://www.youtube.com/user/Derrgis#p/u/8/F6KHGFOknvc

Il y aussi un développeur qui tout récemment a créé SYNAPSE, une application Mac qui envoie la position des parties du corps à Max, Quartz Composer ou même Live: http://synapsekinect.tumblr.com/post/63 … for-kinect

Pour finir un peu d'art, la compagnie 1nOut a fait un spectacle de danse extra avec la kinect:

http://vimeo.com/21385114

![]()

![]()

![]()

![]()

Hors ligne

#7 2011-09-07 21:52:27 Re : Demande de retours d'expérience Kinect et Max

Re: Demande de retours d'expérience Kinect et Max

Mmm... Sans vouloir dérailler le sujet, je me pose pas mal de questions sur cette technologie. Peut-être faut-il ouvrir un nouveau sujet dans une catégorie autre que "max".

Ce qui me choque c'est que finalement la machine suit toujours l'homme. Elle ne lui répond pas, elle refait ce qu'elle voit, ni plus ni moins. Il y a quelques variantes, mais le geste humain est souvent bien plus fin.

De plus par la taille des images projetées et la fascination naturelle de n'importe qui pour les écrans, ça ne fait que bouffer le performeur et je me dis que finalement vu que l'image suit le mouvement, on ne perd pas grand chose au passage puisque c'est une redite, juste un peu de finesse et d'expression dans le geste...

Enfin, si vous voulez en débattre sans que ça vire à la querelle des vieux chnoques contre les modernes qui n'arrivent pas à s'écouter, je suis curieux de votre rapport esthétique à cette technologie.

Hors ligne

#8 2011-09-07 22:48:17 Re : Demande de retours d'expérience Kinect et Max

Re: Demande de retours d'expérience Kinect et Max

Merci Kyred pour ce récapitulatif...

Je ne sais plus où j'avais lu ça, mais je croyais que le projet autour de la kinnect concernait un traducteur temps réel de langue des signes (pour sourds & co)...

Que la partie software était plus ou moins au point mais que, finalement, cela revenait trop cher en optique... donc basta...

Ça ne vous dit rien ce truc ?

citation :

je suis curieux de votre rapport esthétique à cette technologie.

Je vais être dur, mais si le côté technique semble maitrisé par 1n0ut, je ne suis vraiment pas convaincu par les choix esthétiques du rendu vidéo... (mais vraiment, vraiment pas)

Du coup, ça ne peut que donner de l'eau à ton moulin Pob...

Malgré cela, je ne serai pas aussi pessimiste sur le potentiel artistique de cette techos... mais c'est juste un sentiment...

L'Amour au Peuple !

Hors ligne

#9 2011-09-07 23:24:06 Re : Demande de retours d'expérience Kinect et Max

Re: Demande de retours d'expérience Kinect et Max

marrant le débat qui s'ouvre . J'ai investi dans le machin y'a 9 mois , pris comme d'hab du plaisir à la mise en place logicielle, fait deux trucs avec oscleton et gephex et gem puis je suis revenu à l'exploration des possibles avec un bête webcam à 4 balles . N"empêche, j'avoue que c'est en partie par flemme (aussi parce quil vaut mieux être 2 pour les essais - 1 qui code, l'autre qui fait le singe- seul c'est un peu infernal) : par flemme parce que la kinect offre une telle profusion de possibles que çà m'a bloqué un peu et que j'ai préféré le flou (artistique)moins précis d'un outil moins performant . Choix esthétique plus trouble sans doute mais que j'ai préféré .

le code est l'alchimie de l'âge du silicium

Hors ligne

#10 2011-09-08 00:07:29 Re : Demande de retours d'expérience Kinect et Max

Re: Demande de retours d'expérience Kinect et Max

Je pense que le rapport entre la présence sur scène de performeurs/danseurs ou de musiciens avec un écran est exacerbée par le mode de jeu qu'engendre la kinect.

Dans ce que je fais avec mon dispositif où il y a une webcam qui ne prend qu'un champ réduit, c'est vraiment un point important et que je ne pense pas avoir résolu de façon satisfaisante. Pas pour l'instant...

Alors quand je vois une kinect qui incite à rentrer dans ce rapport, je me dis que les créateurs ne se sont pas placé du tout du point de vue du spectateur. Je vois surtout le côté démo technologique. Ce rapport avec l'image projetée, plane et surdimensionnée peut être intéressant pour justement jouer avec le regard du spectateur, le pousser dans une situation où il va devoir choisir entre l'humain sur scène et sa représentation technologique hors dimensions (à plus d'un sens). Il y a une compétition ou alors il faut repenser la projection et du coup certainement l'ensemble du dispositif si on ne veut pas de cette lutte pour capter le regard. Je pense que pour arriver à voir la projection sans écraser l'humain ça demande un peu de travail... ![]()

Dernière modification par pob (2011-09-08 00:09:42)

Hors ligne

#11 2011-09-08 00:56:03 Re : Demande de retours d'expérience Kinect et Max

Re: Demande de retours d'expérience Kinect et Max

tout à fait d'accord et çà commence sans doute par éviter de projeter ce que l'humain "performe", çà n'a guère de sens que l'humain soit présent sur la scène même pour les "premiers rangs . Sauf à trouver un autre rapport dans ce dédoublage .

le code est l'alchimie de l'âge du silicium

Hors ligne

#12 2011-09-08 19:37:57 Re : Demande de retours d'expérience Kinect et Max

Re: Demande de retours d'expérience Kinect et Max

Ce débat et tous ces points de vue ouvrent des perspectives de réflexion passionnantes.

Il y a absolument de tout ça dans cette et dans "ces" technologie(s). Et bien davantage encore.

Robotique, vision par ordinateur et intelligence artificielle. Art et esthétique. Scénographie et rapport au public, relation au dispositif, au double numérique. Geste expert versus geste non-spécialisé. Composition, conception des modalités d'interaction. Notions de corps et de sensibilité. Prolongement du geste et ainsi de suite.

En effet nous pourrions ouvrir une rubrique dans ce sens sur le forum. A discuter avec l'équipe de codelab.

Dans un premier temps nous pouvons consigner librement ici des liens relatifs à ces champs:

• sites web

• vulgarisations, résumés

• ouvrages et articles

• rapports, thèses, mémoires

Qu'en pensez-vous?

Je démarre avec l'ouvrage de Florent Aziosmanoff "Le Living Art" , une forme d’expression spécifique au medium numérique. 2010, CNRS Editions - Paris", paru

Hors ligne

#13 2011-09-08 19:47:09 Re : Demande de retours d'expérience Kinect et Max

Re: Demande de retours d'expérience Kinect et Max

On peut aussi en parler sur l'IRC de codelab... ![]()

freenode #codelab tout simplement !

Hors ligne

#14 2011-09-08 20:11:11 Re : Demande de retours d'expérience Kinect et Max

Re: Demande de retours d'expérience Kinect et Max

Il y a aussi la section "Culture(s) : penser la technique et pas seulement la technologie" qui me semble assez appropriée.

L'Amour au Peuple !

Hors ligne

#15 2011-09-08 23:18:52 Re : Demande de retours d'expérience Kinect et Max

Re: Demande de retours d'expérience Kinect et Max

Olivier a écrit:

Il y a aussi la section "Culture(s) : penser la technique et pas seulement la technologie" qui me semble assez appropriée.

Oui, c'est une bonne idée de créer un nouveau sujet dans la section cultures

Hors ligne

- Accueil forums

- » Max/MSP - Jitter

- » Demande de retours d'expérience Kinect et Max

fil rss de cette discussion :